易混基礎概念

在 Numpy 中定義矩陣的方法,以及進行轉置的方法:

import numpy as np

a = np.array([[1, 2, 3],

[4, 5, 6]])

a = a.reshape(3, 2)

print(a)

[[1 2]

[3 4]

[5 6]]

複制代碼

與高等數學中矩陣相乘内容一緻:

a = np.array([[1, 2],

[3, 4]])

b = np.array([[5, 6],

[7, 8]])

print(a * b)

print(a.dot(b))

print(np.dot(a, b))

print(np.linalg.inv(a))

# 星(*)

[[ 5 12]

[21 32]]

# 點乘

[[19 22]

[43 50]]

# 點乘

[[19 22]

[43 50]]

# 逆運算

[[-2. 1. ]

[ 1.5 -0.5]]

複制代碼

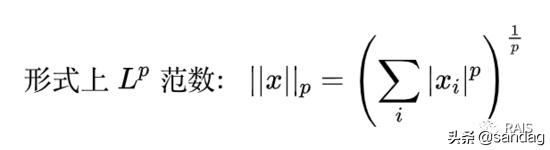

範數是一個函數,用于衡量長度大小的一個函數。數學上,範數包括向量範數和矩陣範數。

我們先讨論向量的範數。向量是有方向有大小的,這個大小就用範數來表示。

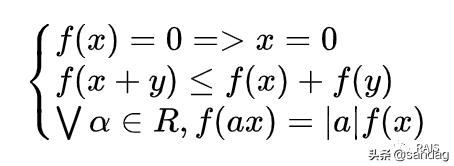

嚴格意義上來說,範數是滿足下列性質的任意函數:

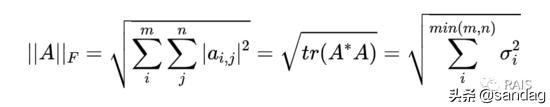

對于矩陣範數,我們隻聊一聊 Frobenius 範數,簡單點說就是矩陣中所有元素的平方和再開方,還有其他的定義方法,如下,其中表示的共轭轉置,tr為迹;表示的奇異值:

我們熟悉特征分解矩陣中:,奇異分解與之類似:,其中矩陣的行和列的值為、正交矩陣、對角矩陣、正交矩陣,矩陣對角線上的元素稱為的奇異值,其中非零奇異值是或的特征值的平方根;稱為的左奇異向量,是的特征向量;稱為的右奇異向量,是的特征向量。因為奇異矩陣無法求逆,而求逆又是研究矩陣的非常好的方法,因此考慮退而求其次的方法,求僞逆,這是最接近矩陣求逆的,把矩陣化為最舒服的形式去研究其他的性質,僞逆把矩陣化為主對角線上有秩那麼多的非零元素,矩陣中其他的元素都是零,這也是統計學中常用的方法,在機器學習中耶非常好用。

線性代數的一大特點是“一大串”,統一的知識體系,相互之間緊密聯系,非常漂亮,在深度學習中有重要的應用,還是應該要學好。

,更多精彩资讯请关注tft每日頭條,我们将持续为您更新最新资讯!