用于機器人倫理試驗的Nao機器人

科幻作家伊薩克•阿西莫夫(Isaac Asimov)在多部科幻小說中,經常提到機器人的工程安全防護和倫理道德标準。在1942年科幻小說《環舞》(Run around)中,他提出了機器人技術三大定律:

1.機器人不能傷害人類,不能抽手旁觀坐視人類受到傷害;

2.機器人應服從人類指令,除非該指令與第一定律相背;

3.在不違背第一條和第二條定律情況下,機器人應保護自身的存在。

最近,務實的機器人專家們一直在議論阿西莫夫定律,他們認為,機器人現在越來越自主,為使它不成為脫缰之馬,必須給予其指導和約束。2015年五月,由布魯金斯學會舉辦的一次無人駕駛汽車論壇上,學者們對無人駕駛汽車遇到危急時的處理方式進行了讨論。會上有人提出,為保護自己或乘客,汽車突然刹車該如何規避後車碰撞?或汽車為規避行人而突然轉彎又如何避免傷害到其他人?

出席這次論壇的德國西門子公司工程師卡爾•J•庫恩(Karl J.Kuhn)認為,随着越來越多的自動化設備出現在我們的日常生活中,研究人員應該研發能在“二次危機中”做出正确選擇的智能機器人。

是的,這些問題正在或已經影響到護理保健機器人、無人飛行器和其他自動化智能裝置的研制,這些設備既能幫助人,亦能傷害人。研究人員越來越相信,人們對這些自動化設備的接受程度,取決于它們的安全性、适應社會道德規範和對其的信任度。加拿大溫莎大學的哲學家馬塞洛•戈裡尼(Marcello Guarini)說:

隻有徹底解決倫理方面的問題,人工智能才能取得實質性進步。

包括美國海軍研究辦公室(ONR)和英國工程基金會等機構資助的一些課題或項目,正在應對這方面挑戰,盡管都是一些非常棘手的科學難題,例如,倫理決策采用的智能方法和具體要求,以及如何将其轉換成機器指令。這就需要計算機科學家、機器人專家、倫理學家和哲學家通力合作、全身投入。

英國布裡斯托爾機器人實驗室的機器人專家艾倫•溫菲爾德(Alan Winfield)說:

如果五年前有人問我能否制造出有倫理意識機器人,我會說不,認為這種想法太天真、太瘋狂。現在卻不這樣想了。

善于學習的機器人

在機器人領域,一個經常談到的實驗是提醒病人吃藥的Nao商業機器人。

從表面判斷,整個事情似乎很簡單。但這種簡單涉及許多不一般的倫理學問題。

康涅狄格州立大學的哲學家蘇珊•L•安德森(Susan L. Anderson)說。假如病人拒絕吃藥,Nao機器人該如何處理?聽從病人的話可能會引發傷害,而堅持給藥又影響病人的自主性。安德森的丈夫是康涅狄格州哈特福德大學計算機科學家邁克爾•安德森(Michael Anderson)。

為使Nao機器人應對上述窘境,安德森夫婦與生物倫理學家們就機器人自主性、幫助病人和可能造成的傷害等問題做了大量的案例分析,經分類後,他們創建了一個學習算法(Learning algorithms),最終為引導機器人找到了适應不同情況的新模式。

裝有“學習算法”程序的機器人,可從模棱兩可的信息輸入中提取有用知識。從理論上說,這種方法可幫助機器人遇到複雜情況時更好做出符合倫理學的選擇。但很多人擔心,這勢必會造成機器人成本高昂。對此,在斯坦福大學教授人工智能和倫理學的傑瑞•卡普蘭(Jerry Kaplan)則認為,這些原則未寫入計算機代碼,

你無法知道一個程序為何有一個特定規則說明某事倫理上的‘對’或‘錯’。

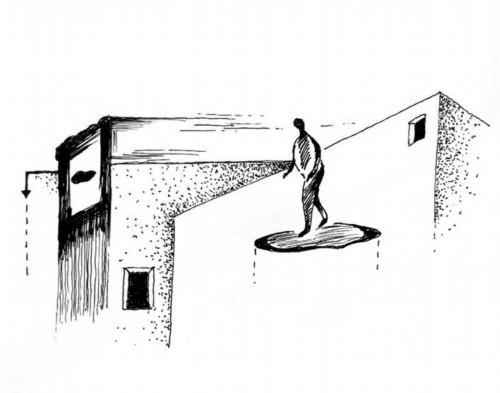

很多工程師認為,解決這個問題可采用多種方式,包括嘗試用程序明确地創建規則,而不是要求機器人自己推斷處理。溫菲爾德去年發表了一篇報告,其中提到,若有人掉進洞穴,機器人會用哪一種程序實施救援?溫菲爾德認為,很明顯,機器人需具有感知環境的能力——找到洞穴位置和人在何處,以及自身與它和他的相對位置。此外,機器人還要預見自己行為可能産生的後果。

溫菲爾德采用冰球大小的機器人進行了試驗,并對機器人分類:H-機器人表示人類,A-機器人代表倫理機器人(設置了阿西莫夫機器人三大定律的第一定律程序)。若A-機器人覺察到H-機器人掉進洞穴,它應該進入洞穴給予救援。

照料病人或老人的Robear護理機器人

通過數十次試驗,溫菲爾德發現,A-機器人每次都能肩負自己承擔的責任。為了弄清在道德兩難面前不傷害法則的執行情況,他讓A-機器人與二個H-機器人同時進入危險區。看看情況又會如何呢?

結果顯示,倫理機器人能發揮作用,即使設定的标準較低,A-機器人通常會救“人”。首先移向臨近的那個,如果動作迅速,有時能同時救“二人”。試驗結果也表明,受設定标準限制,在近乎一半試驗中,A-機器人會出現顫抖(猶豫)現象,處于兩難境地,最終造成兩個“人”死亡。為解決這個問題,必須要提供解決問題的額外規則。例如,H-機器人是成年人,另一個是孩子,那麼A-機器人先該救哪個呢?對于類似事情,人類本身都難取得一緻意見。正如卡普蘭所指出的:

我們都不知道如何編制那些明晰而又不一定完整的規則。

機器人倫理規則

擁護者認為,有規則才能取得好成果:機器人之所以做出這種選擇,是設計者設置的規則。就美國軍方而言,自動化系統是其重要的戰略目标,無論是救援還是執行戰鬥任務。喬治亞理工學院從事機器人倫理軟件設計的羅納德•阿金(Ronald Arkin)說:

可能你最不願做的一件事就是派遣機器人上戰場,并為其制定應遵循的倫理規則。

因為在戰場上,機器人會遭遇援救戰士和追逐敵人兩者之間的選擇,必須讓它提前知道。

在美國國防部的資助下,阿金設計了一個在戰鬥中确保軍用機器人遵照國際交戰協定的軟件程序:一種名叫倫理控制器的算法軟件用于評估某一軍事行動可否執行,如發射導彈,機器人必須回答“yes”或No。

在一次倫理控制器虛拟測試中,一架無人飛機模拟打擊敵人目标,但不得破壞附近平民居住的建築物。無人飛機、打擊區域與平民設施(如醫院和住宅建築)位置是相對變動的,算法軟件最終可以決定無人飛機何時執行任務。

開發軍用機器人引起人們擔心并引發許多争議。阿金認為,隻要程序設置符合戰争規則,機器人在某些情況下會比真人做得更好,而人類在戰争中有可能會更瘋狂。

在編寫機器人倫理程序時,不少計算機科學家喜愛用邏輯語句代碼,如“若是真的,向前移動;若是假的,不要動。”葡萄牙裡斯本大學計算機科學和信息技術實驗室的計算機科學家魯斯•M•佩雷拉(Luís M.Pereira)認為,邏輯性是機器倫理編碼的理想選擇,“它是我們推導倫理方案的基礎。”

編制正确倫理決策的邏輯程序是一項富有挑戰性的工作。佩雷拉注意到,盡管計算機程序邏輯語言對假設情況難以得出正确結論,但在解決某些倫理困境是至關重要的。

假設用突然失控的軌道車比喻,其可能撞死軌道上五個人,若拉動操縱杆改變軌道路線,又可能撞上旁邊一個人。怎麼辦?唯一的辦法就是在改變路線的同時緊急刹車,最大程度的減少傷亡。

人們通常認為,軌道車刹車是應該的,但不接受讓其沖向一個人的主張。而哲學家雙重效應學說的基本直覺是不允許故意傷害他人,哪怕有好的結局。盡管人們通常很少責備非故意事件。

用決策分析程序做出倫理判斷是非常困難的。首先,程序必須能預測二種不同的結果:軌道車要麼撞上五個人,要麼就沖向另一個無辜者。程序還必須回答下面問題:若不變軌,會造成五人傷亡;若變軌,又會造成另一人傷亡,盡管減少了傷亡人數。

行駛在加利福尼亞街區的谷歌無人駕駛汽車

讓機器适應人類

為了找到解決辦法,程序開發還必須充分考慮到偶發事件的可能,即若不變軌,緊急刹車後事實上又将會發生什麼?佩雷拉說:

這要求程序能自行調試、找出發生變化的代碼位置并預測其結果。

佩雷拉和印度尼西亞大學計算機科學家阿裡•薩普塔維亞(Ari Saptawijaya)合作完成了一款邏輯推理程序軟件。該程序軟件依據雙重效應學說和更先進的三重效應理論可做出倫理判斷,充分考慮了造成的傷害是否故意,或是不可避免的。

大多數研究人員認為,倫理機器人的開發對未來機器人技術的發展有重大意義。英國利物浦大學的計算機科學家邁克爾•費希爾(Michael Fisher)認為,制定機器人規則約束系統可以讓公衆放心。

有些人不了解機器人未來将帶來什麼,因而會感到恐懼。如果通過對機器人行為原理的分析和實證,公衆完全能信任它。

費希爾和溫菲爾德等專家,目前正在從事一個政府資助項目,以驗證倫理機器人軟件程序的可靠性。

與一些剛性程序相比,機器人學習程序可以幫助機器人從經驗中獲得知識,進而行動更柔性、更靈活、更适用。許多機器人專家認為,組合方法可能是未來的方向。佩雷拉說:“這有點像心理療法,采用的不是一種理論。”但把多種方法綜合在一起仍是一場挑戰,至今沒有得到解決。

在智能交通領域,不久就會面臨這些問題。谷歌無人駕駛汽車已經穿梭在加利福尼亞部分地區。今年五月,德國汽車制造廠商生産的戴姆勒無人駕駛卡車在美國西部的内華達沙漠中行駛。

工程師們現在要認真思考的問題是,如何讓汽車既遵守規則又适應道路狀況。德國斯圖加特的戴姆勒工廠發言人說:

我們一直在嘗試用機器人替代人類從事惡劣環境下的勞動。社會的進步,就得嘗試讓事物更适應人類,而不是機器。

轉載自微信公号“世界科學”。

,更多精彩资讯请关注tft每日頭條,我们将持续为您更新最新资讯!